Zurück in die Kindheit – Infantilisierung im UI Design

Zurück in die Kindheit – Infantilisierung im UI DesignEinreichung von Matthias Müller-Prove zur HyperKult XX

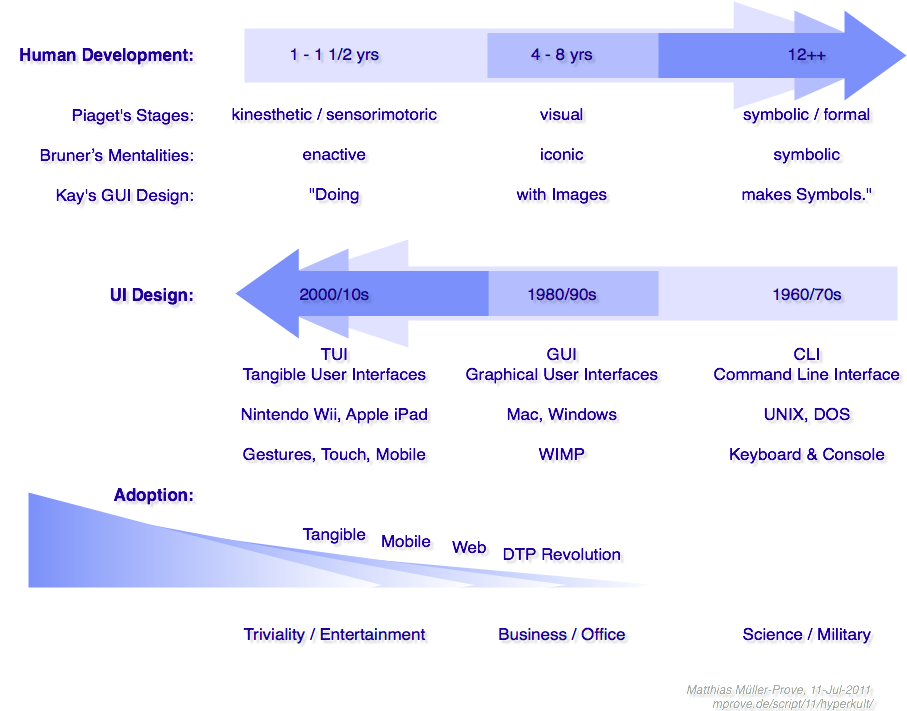

Mit der jüngsten Entwicklung von „mobilen Endgeräten“ und Spielekonsolen schließt sich ein Kreis. Denn genau wie sich der Mensch von der Kleinkindphase – alles muss angefasst und ausprobiert werden – über die Kindheit mit Schauen, Malen und Basteln, hin zum Erwachsenen, dem manchmal auch rational denkenden Homo Sapiens, entwickelt, hat sich die Computer-Technik in den letzten fünfzig Jahren in umgekehrter Richtung vom textbasierten Teletype, über die graphischen Benutzungsschnittstellen vom Apple Macintosh und Co., hin zu maus- und fensterlosen Geräten für mobile Kommunikation und Unterhaltung gewandelt. Gesten und Finger-Touch ersetzen bei Tangible User Interfaces (TUI) – oder auch Natural User Interfaces (NUI) – das Klicken und Tippen, das bei GUIs und CLIs noch die Hauptinteraktionsmodalität waren.

Dieser Artikel vertritt die beiden folgenden Thesen:

Zunächst also über die Entwicklung und das Lernen eines Kindes hin zum Erwachsenen. (Die Darstellung folgt Thee Stages of Human Development in Müller-Prove 2002.)

Jean Piaget beschäftigt sich in den 1920er Jahren mit der Frage wie Kinder lernen. Seine Theorie erklärt, warum Kinder in verschiedenen Altersphasen unterschiedliche Lernansätze verfolgen. Demzufolge entwickeln sich Menschen in vier aufeinanderfolgenden Phasen. Die sensomotorische Phase dauert in etwa 1 ½ Jahre. Hier ist das Verhalten des Kindes hauptsächlich reflexiv; Personen und Gegenstände können aber schon unterschieden werden. Die darauf folgende präoperationale Phase dauert bis zum Alter von ca. 4 Jahren. Das Kind beginnt zu Sprechen, und es hat eine Vorstellung von der Größe von Gegenständen – aber noch kein Verständnis für Volumen und Masse. Alles wird im wortwörtlichen Sinne begriffen und in den Mund gesteckt. Zwischen 4 und 8 Jahren liegt die konkret operationale, bzw. die visuelle Phase. Kinder spielen mit Legosteinen oder Konstruktionsbaukästen und malen gerne. Die vierte und letzte Phase der kindlichen Entwicklung ist die formal-symbolische Phase. Sie ist geprägt von logischem Denken, Hypothesenbildung, Schlussfolgerungen und Denken in abstrakten Begriffen.

Jerome Bruner, Psychologe wie Piaget, hat viele von Piagets Experimenten in den 1960er Jahren bestätigt. Aber sein Erklärungsmodell geht über Piagets Phasenmodell hinaus. Bruner gliedert die Entwicklung in eine Reihe kognitiver Fähigkeiten (mentalities) – handelnd (enactive), bildhaft (iconic) und symbolisch (symbolic) – und findet Entsprechungen zu Piagets Phasenmodell. Die erste spielerische Phase entspricht der handelnden Kognition. »Learning is accomplished by doing. A baby learns what a rattle is by shaking it. A child learns to ride a bicycle by riding one«, so David Canfield Smith (1993), der „Vater“ der Icons. Bildhafte Kognition bestimmt die Phase bis ca. 8 Jahre. Nochmals Smith: »Learning and thinking utilizes pictures. A child learns what a horse is by seeing one or a picture of one.« Die logische-formale Phase entspricht dann der symbolischen Kognition.

Den kognitiven Fähigkeiten des Menschen werden nun die Entwicklungen in der Computer-Technik gegenüber gestellt.

Tastatur und Terminal-Bildschirm sind die charakterisierenden Ein- und Ausgabegeräte der Command Line Interfaces. Als Eingabemedium dient eine formale Sprache, die Zeile für Zeile eingetippt und dann vom Computer validiert und interpretiert wird. Bei syntaktischen Eingabefehlern reagiert das System unwirsch mit Fehlermeldungen. Die Bedienung wird dadurch sehr technisch abstrakt und erschließt sich nicht einfach für den unversierten Nutzer.

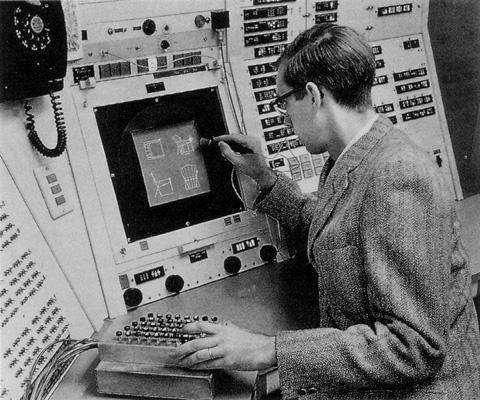

Erst der kommerzielle Erfolg der graphischen Benutzungsschnittstellen in den 1980er Jahren bedingt eine Verbreitung von Computern in fast allen Bereichen des Arbeitsalltags. Die Voraussetzungen der PC-Revolution wurden allerdings schon in den 1960er Jahren von Ivan Sutherland am MIT Lincoln Laboratory und Douglas Engelbarts Team am Stanford Research Institute gelegt. Ivan Sutherlands Sketchpad war 1962 das erste interaktive Zeichen- und Konstruktionsprogramm der Welt; bedient wurde es mit einem Lichtgriffel (siehe Abb. 1). Ein Jahr danach entwickelten Bill English und Doug Engelbart die Maus, die bei NLS/Augment als Zeigeinstrument diente. Außerdem beherrschte NLS/Augment interaktive Texterstellung mit Hyperlinking, und unterstützte Arbeitsgruppen per Screen-Sharing und Videokonferenz (Computer Supported Cooperative Work). Zu erwähnen ist auch ein spezielles 5-tastiges Chording-Keyset, mit dem sich durch gleichzeitiges Anschlagen mehrerer Tasten 31 verschiedene Kommandos oder Zeichen eingeben ließen. Damit kann NLS/Augment auch als Vorläufer von Multitouch-Systemen angesehen werden.

Abb. 1: Ivan Sutherlands Sketchpad (1962) wird mit einem Lichtgriffel und einer Kommando-Tastenfeld (unter der linken Hand) bedient. Die Position und Größe der Graphik kann mit den vier Drehreglern eingestellt werden. Hier abgebildet ist wahrscheinlich Timothy Johnson Mitte der 1960er Jahre.

Seymour Papert bezieht sich für sein Design der Programmier- und Lernumgebung Logo im Jahre 1967 auf Piagets und Bruners Arbeiten und schließt, dass es nicht sinnvoll ist, Kindern vor Eintritt in die dritte logisch-formale Phase abstrakte mathematische Prinzipien beibringen zu wollen. Daher ist die Turtle – ursprünglich ein mit einem sehr einfachen Befehlssatz steuerbarer Roboter – ein schönes Beispiel dafür, wie der Spieltrieb der konkret operationalen Phase stimuliert wird, um die Schildkröte zum Malen zu bewegen.

Alan Kay und Adele Goldberg arbeiten in den 1970er Jahren am Xerox PARC ebenfalls mit Schulkindern. Daraus entwickeln sie die konsequent objekt-orientierte Programmiersprache Smalltalk, die als Experimentierumgebung für das Interface-Design des Xerox Alto eingesetzt wird. Alan Kay prägt für den Vorläufer der heutigen graphischen Benutzungsschnittstellen das Motto »Doing with images makes symbols.« (Kay 1987) Doing bezieht sich im Gegensatz zu den bis dato üblichen Kommandozeilenschnittstellen auf den Einsatz der Maus als Zeigeinstrument im virtuellen Raum eines abgebildeten Büroschreibtisches. Die Analogie mit einem physikalischen Arbeitsplatz soll dabei den Anwendern die Scheu vor der Maschine nehmen und auf ihr Alltagswissen rekurrieren. Fenster überlappen sich ähnlich wie Seiten aus echtem Papier und können mit einem Mausklick neu angeordnet werden. Die kleinen Images heißen Icons und wurden von David C. Smith beigesteuert. Das Klicken, Doppelklicken, Selektieren, Drag'n'Drop mit jeweils unterschiedlichem Objekt auf ein Ziel-Icon oder Ziel-Fenster löst je nach Kontext eine unterschiedliche abstrakte symbolische Aktion aus. »Doing with images makes symbols.«

Mit der alleinigen Bedienung der Maus ist die Hand allerdings unterfordert, bedenkt man zum Beispiel die Fertigkeiten eines Pianisten oder die Gebärden von Gehörlosen. Gestensteuerung ist daher die konsequente Weiterentwicklung der Maus, die prinzipiell nur eine Bildschirmkoordinate bestimmt und mit einigen zusätzlichen Buttons und Rädchen ausgestattet ist, um an der jeweiligen Position eine Aktion auszulösen. Gesten können hingegen sehr viel ausdrucksstärkere Kommandos ausdrücken, die nach kurzer Eingewöhnung als natürlich empfunden werden. Ein paar von den Standardgesten auf Apples iPad sind Flick, Swipe, Double tap, Pinch open, Pinch close, Touch and hold. Mit zwei Fingern lassen sich Objekte auch leicht drehen; weitere Gesten sind von den Interaktions-Designern fast ohne Beschränkung definierbar, gelten dann aber meist nur noch im Kontext einer einzelnen Anwendung. Letzlich kann auch das ganze Gerät geschüttelt und geneigt werden; die Nintendo Wii ist hier der prominenteste Vertreter für Tangible User Interfaces im Spielesektor.

Alan Kay hebt hervor, dass Piagets Phasenmodell und Bruners Modell der kognitiven Fähigkeiten nicht nur als chronologische Abfolge zu sehen sind, sondern als gleichzeitig vorhandene Fähigkeiten eines erwachsenen Anwenders. Obgleich Erwachsene in der Berufswelt dazu tendieren das Spielerische und Bildhafte als kindlich zu diffamieren, entfalten sich erst in der Kombination aller kognitiven Fähigkeiten (im Brunerschen Sinne) Kreativität und neue Erkenntnisse.

Abb. 2. Gegenüberstellung des menschlichen Erwachsenwerdens und der Evolution im User Interface Design

Und auch in der Computer-Welt überlagern sich die Interaktionsmodalitäten. Dazu ein paar Beispiele:

Trotz der Gleichzeitigkeit der unterschiedlichen Interaktionsmodalitäten bevorzugt doch jede Geräteklasse ihr eigene spezifische Inhalte. CLIs bieten bei automatisierten und systemnahen Prozessen unter Windows, Linux und MacOS Vorteile, die nicht annähernd so gut mit GUIs oder TUIs umzusetzen wären. GUIs haben aus gutem Grund in den 1980er Jahren die Desktop Publishing-Revolution ausgelöst, da die Fenster, Icons, Menüs und Maus zusammen mit einer druckgetreuen Bildschirmdarstellung – das sogenannte WYSIWYG-Prinzip (what you see is what you get) – die Erstellung elektronischer Dokumente anschaulich und verständlich machte. Multitouch-Geräte und TUIs schließlich erobern sich den Unterhaltungssektor und laden zum Malen mit den Fingern ein. Marshall McLuhans berühmter Satz »The medium is the message« lässt sich mühelos auf das Computer-Medium übertragen.

Eine Infantilisierung des Medium wäre nur dann zu beklagen, wenn die anderen Interaktionsmodalitäten völlig in den Hintergrund gedrängt würden und nur die spielerisch kindlich kognitiven Fähigkeiten des Menschen eine Entsprechung fänden. So obliegt es aber dem Systemdesigner dasjenige Computer-Medium zu wählen, das für die Anwendung am geeignetsten ist; und auch dem Anwender sich diejenigen Devices und Services auszusuchen, mit denen er seine intellektuellen Aufgaben und spielerischen Bedürfnisse am besten bewältigen kann.

Dem Homo Sapiens und dem Homo Ludens, dem denkenden und spielenden Menschen, steht heute das komplette Spektrum an Computersystemen zu Verfügung, die alle seine kognitiven Fähigkeiten fördern und unterstützen können.

Back to Childhood – Infantilisation of UI Design /slides and video